Многие начинающие вебмастера сталкиваются с вопросом: где находится файл robots для сайта и как его создать и правильно настроить в формате расширения txt. В этой статье, я кратко расскажу как это сделать. Нужно отметить, что формат файла всегда один и располагается он всегда в одном месте, независимо от того, на каком движке работает ваш сайт, будь то WordPress, Joomla, Битрикс и так далее.

Содержание:

- Где находится файл robots.txt

- Какие директивы нужно прописать и примеры файла

- Как сделать файл robots.txt

- Как проверить файл robots.txt

Где находится файл robots.txt?

Если вы только что создали сайт, то файла robots.txt у вас еще нет. Его нужно самостоятельно сделать (см.ниже). Посмотреть, как выглядит файл, можно на любом сайте. Для этого зайдите на главную страницу сайта и после основного адреса, поставьте слэш (косая черта) и напишите robots.txt. Потом нажмите на Enter. У вас откроется файл Роботс. Сам файл robots.txt, располагается в корневой папке файлов хостинга и так и называется robots.txt.

Какие директивы нужны в файле robots.txt? Пример файла

На данный момент, многие вебмастера уделяют мало внимания этому файлу, так как для поисковой системы Гугл он становится все менее актуальным — американский поисковик желает открытости сайта для любого сканирования. Однако для поисковой системы Яндекс, файл Роботс по-прежнему имеет значение.

В основном в файле robots.txt используется две директивы или команды для поисковых ботов, такие как Disallow (запрет индексации) и Allow (разрешение индексации). С подробной инструкцией, вы можете ознакомится в лайфхаке самого Яндекса.

Пример простого файла robots.txt для молодого сайта на WordPress;

User-agent: Yandex

Disallow: /admin

Disallow: /*?*

Disallow: /wp-json/

Disallow: */page/

Disallow: */feed

Как мы видим выше, в этом файле нет указания на карту sitemap, а также директив Allow. Кроме этого, файл сделан только для Яндекс-бота. Команды для Googlebot и User-agent: * (остальные поисковики) отсутствуют. Как было уже сказано выше, Гугл не просто игнорирует запрещающие команды в файле Роботс, но и присылает уведомление об ошибке, если какой либо контент сайта закрыт командой Disallow.

Однако, если вы не пропишите для Гугл-бота в файле Роботс какие либо команды, то бот Гугла будет ориентироваться на файл User-agent: * (остальные поисковики). Поэтому, если вы не прописали User-agent: Googlebot, то не следует и прописывать User-agent: *.

Пример полного файла для всех поисковиков;

User-agent: Googlebot

Disallow: /admin

Disallow: /wp-json/

Disallow: */page/

Disallow: */feed

User-agent: *

Disallow: /admin

Disallow: /wp-json/

Disallow: */page/

Disallow: */feed

User-agent: Yandex

Disallow: /admin

Disallow: /*?*

Disallow: /wp-json/

Disallow: */page/

Disallow: */feed

На примере полного файла Роботс для всех поисковых систем, мы видим, что для Гугл-бота и остальных Юзер-агентов, не прописана команда запрета индексации Disallow: /*?*. Все дело в том, что один из Гугл-ботов индексирует и стили CSS сайта, в URL которых присутствует знак вопроса. При запрете, Гугл будет видеть ваш сайт, как “голую верстку” HTML и выдаст сообщение “Сайт не оптимизирован для мобильных устройств”.

Примечание: звездочка в командах, означает “до” или “после”.

Что означают команды Disallow на примере сайта на WordPress

- Disallow: /admin — Вордпресс делает дубли статей admin. Нужно закрыть от индексации

- Disallow: /*?* — Вордпресс генерирует множество файлов со знаком вопроса, в том числе в режиме редактирования и предпросмотра статьи. Их зачем-то индексирует Яндекс. Закрываем от индексации.

- Disallow: /wp-json/ — JSON REST API является программой внутри Вордпресс. Делает дубли с wp-json. Закрываем от индексации.

- Disallow: */page/ — закрываем от индексации все страницы рубрик и главной страницы, чтобы избежать дублей. Актуально только для сайтов-информационников. Иными словами, у вас впоследствии будет проиндексирована только первая страница Главной страницы и первая страница любой Рубрики.

- Disallow: */feed — Вордпресс автоматически создает ленту статей с характерным URL. Закрываем от индексации

Делаем файл robots.txt

Для того, чтобы у вас появился файл robots для сайта, нужно сделать его в текстовом формате и с помощью FTP соединения, загрузить его в корневую папку сайта.

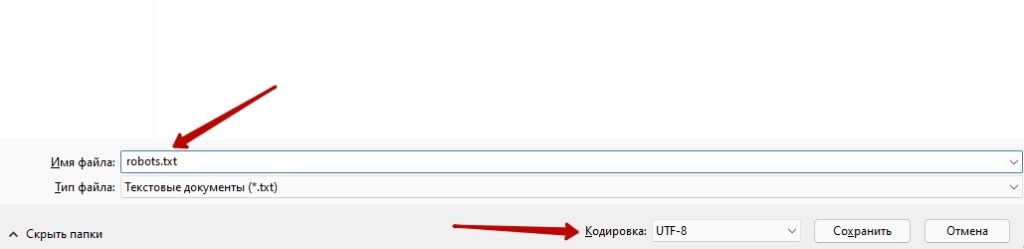

Текстовой файл делается на обычном компьютере с Windows, в котором есть так называемый Блокнот. Этот Блокнот специально создан для этого. Перед сохранением файла, не забудьте перевести расширение файла в этом Блокноте в кодировку UTF-8, а после методом копирования вставить пример файла Роботс. После этого, нужно сохранить файл на рабочий стол, обязательно назвав его robots. Приставку txt система добавит сама.

Примечание: не стоит слепо копировать примеры файла. Вы должны понимать каждую команду. Ошибка может привести к плохой индексации вашего сайта.

Загрузка на файлы хостинга

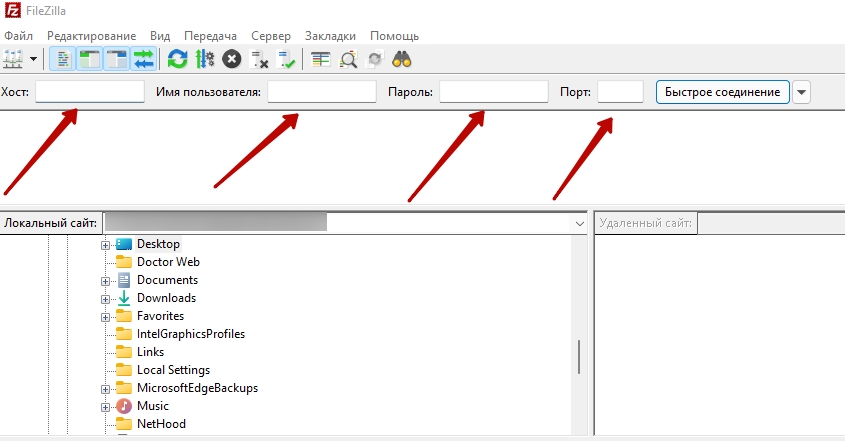

FTP соединение в файлами хостинга или иными словами с файлами вашего сайта на сервере, вы можете установить с помощью бесплатной программки FileZilla, популярной среди вебмастеров. Для этого нужно скачать программу с официального сайта.

Открыв программу, вы должны прописать имя хоста. Как правило, имя хоста написано в аккаунте вашего хостинга, во вкладке “Доступ по FTP”. Также в FileZilla, вы прописываете логин и пароль вашего аккаунта на хостинге, а также номер порта. Номер порта можно узнать в соответствующей инструкции самого хостера или через тех.поддержку. После нужно нажать кнопку Быстрое соединение.

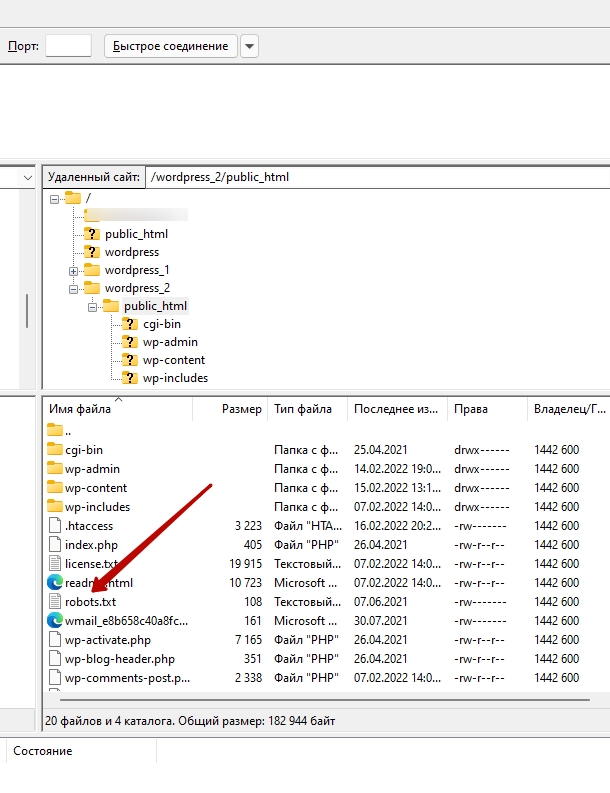

После соединения с хостингом, у вас в правой колонке программки откроются файлы сайта. Корневая папка как правило называется public_html, но может иметь и другое название. В любом случае, ее перепутать трудно, так как в ней много файлов. Простым удержанием мыши, перетаскиваете созданный файл robots.txt в корневую папку. На этом и заканчивается создание файла Роботс.

Читайте также: Лучшие бесплатные темы Вордпресс

Проверка файла robots.txt на индексацию

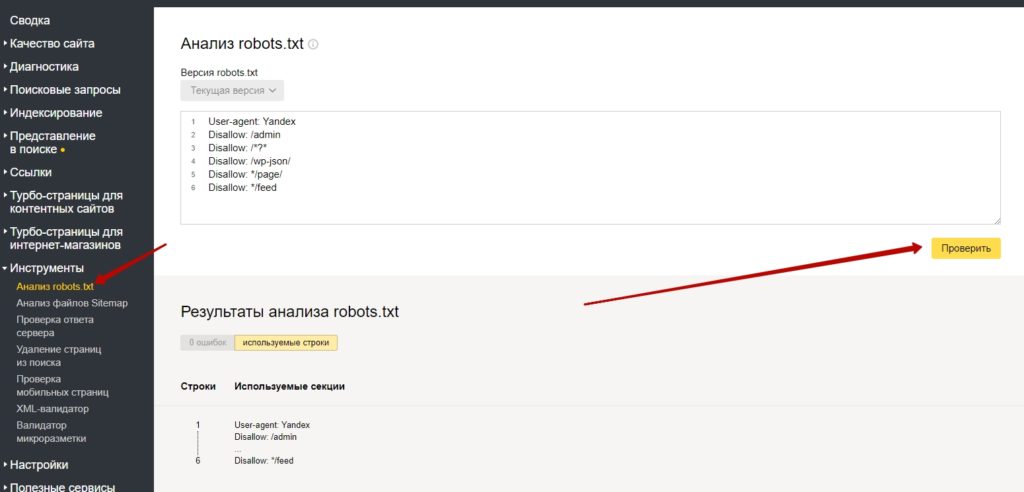

Если ваш сайт зарегистрирован в кабинете Яндекс Вебмастер, то вы можете проверить правильность своего файла Роботс прямо в консоли. Для этого, во вкладке Инструменты, выберете строку Анализ файла robots.txt и нажмите на кнопку Проверить. Вводить данные файла не нужно. Система должна найти его сама на вашем хостинге. Если вы не увидите красных предупреждений, значит с вашим файлом все в порядке и он индексируется.

Нужно отметить, что в данном случае, сервис проверяет файл robots для сайта в контексте правильности написания символов и никак не сигнализирует о том, что у вас может быть закрыт важный контент сайта. Будьте внимательны при составлении файла Роботс.